Anbieter zum Thema

20 Prozent Differenz

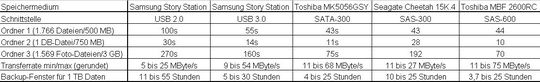

Ich lege drei Ordner an und lasse den Rechner etwas mehr als vier Gigabyte Daten kopieren. Nach 129 Sekunden ist alles vorbei. In meinem persönlichen Triathon schlägt die Toshiba-Disk die Samsung Story Station in allen drei Disziplinen. Korrekt dürfte diese Zusammenfassung allerdings nicht sein.

Denn eigentlich läuft die 3,5-Zoll Festplatte im Samsung Gehäuse mit derselben Geschwindigkeit von 7.200 Umdrehungen pro Sekunde wie die 2,5-Zoll Festplatte von Toshiba. Und der Rest der inneren Werte dürfte ähnlichen Technologien entstammen.

Das wirft einige Fragen auf. Woher kommen die Unterschiede zwischen den Datentransferraten? Gehen tatsächlich 20 Prozent der Performance auf dem Übertragungsweg verloren? Lässt sich die Geschwindigkeit bei der Samsung Story Station noch optimieren?

Kurvendiskussion

Auch wenn Herr Fekl, Eftec IT Solutions, mit der Aufbereitung dieses Artikel ziemlich unzufrieden ist, so trifft er die Intention des Artikel in seinen Ausführungen exakt: „Geschwindigkeit mit Kopieroperationen zu messen ist grober Unfug, es sei denn Sie interessieren sich in erster Linie für die Gesamtleistung eines bestimmten Computers.“

Aus der Sicht eines Storage-Novizen stellt sich mir umgekehrt die Frage, was habe ich davon zu wissen, dass eine Festplatte auf der äußersten Spur mit 130 oder 200 MByte pro Sekunde arbeitet, auf den inneren Spuren dann aber durch die Abnahme der Radialgeschwindigkeit nur noch mit 50 MByte bei sinkender Zugriffszeit durch die längere Bewegungsstrecke des Kopfes. Der normale Anwender kann dieses Wissen nicht nutzen.

Gleichwohl lässt sich aus diesen Unterschieden sogar eine ganz neuartige Systemarchitekturen verfertigen wie der Print-Beitrag über Pillar Data Systems RAID muss besser werden auf Seite 40 aus dem Jahre 2007 zeigt.

In der praktischen Anwendung sind Spitzengeschwindigkeiten ziemlich hinderlich, so meine Sichtweise, für eine Einschätzung des eigenen Systems. Wichtiger scheint mir, den aktuellen und vielleicht auch den darauf folgenden Flaschenhals des Systems erkennen zu können.

Und das scheint, wenn man sich die Angaben von Hr. Fekl bei USB3 anschaut, gar nicht so leicht zu sein. Das von mir verwendete Intel-Motherboard hat z.B. nur einen PCIe-x1-Slot Version 1.1 mit einer Lane und damit einer Basisbandbreite von 250 MByte/s.

Zieht man maßvoll wie ich bin 20 Prozent Overhead plus Protokoll-Konvertierungen durch die Southbridge(?) auf PCIe, von PCIe auf USB3 und von USB3 auf das Festplatteninterface SATA ab, dann ständen nur noch 200 MByte pro Sekunde zur Verfügung.

Für die meisten externen Festplatten wäre diese Bandbreite ausreichend, sofern sie nicht noch von anderen Geräten mit beansprucht wird. Für den Betrieb einer SSD über USB3 mit, wie Hr. Fekl schreibt, 365 MByte pro Sekunde, wäre Geldverschwendungsucht als Motiv anzunehmen.

Eine Relativierung solcher Geschwindigkeiten macht die c´t in einem aktuellen Artikel. Auf 200 MByte pro Sekunde sollen es demnach handelsübliche SSDs bringen. Aber was nutzen solche Aussagen in der Praxis?

In einer Paragon-Pressemitteilung über NTFS für Mac OS X 8.0 steht zum Beispiel: „Mit bis zu 90 MByte pro Sekunde bei Lese- und Schreibvorgängen erreicht NTFS für Mac OS X 8.0 die Geschwindigkeit von nativen HFS+ Treibern.“

Vielleicht finde ich demnächst auch noch ähnliche Angaben für NTFS selbst oder für das ZFS-Dateisystem von Sun, von dem behauptet wird, es sei extrem schnell. Auf den Flaschenhals Dateisystem hat Hr Fekl ja ebenfalls hingewiesen.

Und wenn das Dateisystem schon unter 100 MByte/s schlapp macht und nur die Hälfte oder gar nur ein Drittel der Performance übrigbleibt, stellt sich schon die Frage, wozu taugen die theoretisch sehr schnellen, aber auch teuren SSDs (gegenwärtig 2 € pro GByte) in einem Desktop-Computer.

[Diskussion to be continued]

Desktop mit SAS-Festplatte

Neben dem Rechner von der Stange mit USB3 und SATA-300, gibt es ja noch die Möglichkeit seinen Desktop-Computer mit Highspeed-Festplatten auszustatten. Parallel-SCSI und Fibre Channel als Auslaufmodell sind nicht mehr erste Wahl. Mein modernes Desktop-Board mag schon den 64-Bit SCSI PCI-X-Adapter nicht, der in unserem Lab seiner vollständigen Verstaubung entgegensieht.

Beim DP55KG glaubt Intel, der Abwärtskompatibilität mit zwei PCI-X-Slots zu genügen. Also weitersuchen. Nachdem sich ein älteres Adaptec-Board, eine ältere Seagate SAS-300- und eine moderne Toshiba SAS-600-Festplatte in unserem Fundus auftreiben lassen, wage ich mich auch noch an dieses Thema.

Leider mit mir vollkommen unverständlichen Ergebnissen wie die nachfolgende Tabelle deutlich macht.

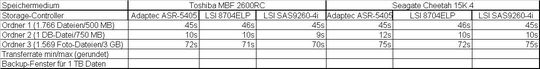

Neustart auch bei meinem SAS-Test. Nachfolgend die tabellarische Zusammenfassung der Kombination von zwei Festplatten und drei sehr unterschieddlicher SAS-Controller. Mir stand der etwas ältere Adaptec Controller ASR-5405 mit 256 MByte Cache zur Verfügung.

Der beiden anderen SAS/SATA-Controller stammen von LSI. Der Mega-RAID 8740ELP arbeitet mit 128 MByte Cache und unterstützt die SAS-300-Schnittstelle, der Mega-RAID-Controller SAS9260-4i ist im Vergleich dazu auf der Höhe der Zeit und mit 512 MByte Cache ausgestattet. Als Schnittstelle zur Festplatte kommt SAS-600 zum Zuge.

Bei den Festplatte stand mir die etwas ältere Seagate Cheetah15K.4 zur Verfügung. Sie dreht mit 15.000 Umdrehungen pro Minute. Als zweite, nur mit 10.000 Umdrehungen pro Minute rotierende Festplatte, durfte ich die Toshiba MBF2600RC testen. Sie verfügt im Gegensatz zur Cheetah über eine SAS-600-Schnittstelle. Da sollten sich doch einige interessante Meßergebnisse ermitteln lassen.

Wie die Tabelle zeigt, gibt es, gleich welche Kombination man betrachtet, keine Unterschiede. Die kleinen Abweichungen sind wahrscheinlich dem Ablesefehler der nur sekundengenauen Uhr geschuldet. So lässt sich also die Leistungsfähigkeit der SAS-Controller nicht ermitteln, oder umgekehrt herum betrachtet, macht eine einzelne SAS-Festplatte in einem Desktop-System „keinen Sinn“. Da ist also weiter Nacharbeit notwendig.

[SAS to be continued]

(ID:2045971)

:quality(80)/p7i.vogel.de/wcms/b5/ad/b5ade2e50671d986cabb091cc33de39f/0127234511v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/2d/69/2d69b27f3f8f5f290f7ae2b3d9123b1b/0127206601v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/94/d2/94d28e3faac411c22b54d80ea354d2e3/0124559320v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ca/b3/cab330ef06324344f47f1715af71ffb8/0121296602v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/c5/fb/c5fb41728b220dab9df1ec9ac9b5c831/0129260583v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/c3/22/c32200a1b5fedc6991e9c57ec9d99883/0128183844v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/2e/66/2e663ffafe56d3cf9aec665b141d23b9/0128869154v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/15/a2/15a2d1c7424af9a2988c7e2af97642f2/0129329362v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e1/cf/e1cfb804d2e69ba56d3780834feab1e1/0129321697v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/c4/c1/c4c1fe42662a6551e2ebc3c99ebd0051/0129198055v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/48/bd/48bda3299c454bc897283aefcb12f756/0129198080v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/08/f7/08f7723af211aef162162c94c3fcd128/0129309312v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/95/cf/95cf2fb34d586d217dc5e3b25a3e95a9/0128985704v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/0f/2e/0f2e2807b08d4605fec1c98ff47e2c47/0129205874v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e8/46/e8465c3f75ae00e67d3af2b0a9c84783/0129259282v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/9e/c3/9ec334dbf3696ef4bf61184f8404df74/0128976654v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/7a/9f/7a9f3b18cdb823c15080ca2c26512328/0129097007v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/c5/35/c5358a2cf971e90b1d98ce0e98310fac/0127947160v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8d/ba/8dbad9d01cad30bc520a8d96ba8d9206/0129126406v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/49/dc/49dc894dc0cf366e1dbe311581e93532/0129090635v2.jpeg)

:quality(80)/p7i.vogel.de/wcms/44/b1/44b155fc9c503acb6023e981d75b8060/0129264503v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8a/c4/8ac47e7daa31e2f997946be4ad3a55fb/0129194277v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/60/a8/60a868f9defd2dfc1073ca9ab1aab657/0128019671v1.jpeg)

:quality(80)/images.vogel.de/vogelonline/bdb/1552300/1552323/original.jpg)

:quality(80)/images.vogel.de/vogelonline/bdb/1644500/1644561/original.jpg)

:quality(80)/images.vogel.de/vogelonline/bdb/1641800/1641842/original.jpg)

:fill(fff,0)/p7i.vogel.de/companies/63/db/63dbd1915b7af/2023-fastlta-logo-square-positive.jpeg)

:quality(80)/p7i.vogel.de/wcms/fa/7b/fa7b35b448260051d16e4a507c950add/0129082539v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/1a/d0/1ad01f5d7d966c68b9f793b03263e88a/0128871045v1.jpeg)