Workloads virtueller Maschinen im Storage abbilden Konvergente Systeme leisten mehr mit Openattic und -stack

Die Schnelllebigkeit der IT macht es Unternehmen schwer, den Kauf von Hard- und Software auf Jahre sicher zu planen. Storage, der im vergangenen Jahr gekauft wurde, ist scheinbar zwölf Monate später schon wieder zu klein und lässt sich nur müßig und teuer erweitern. Doch die leistungsfähigen Prozessoren vieler Storage-Systeme sind unterbeschäftigt. Das muss nicht sein.

Anbieter zum Thema

Auch die Virtualisierungsnodes haben die Grenze ihres verfügbaren Arbeitsspeichers oder CPU erreicht und laufen am absoluten Limit. Mit der Anschaffung neuer Speicherressourcen ist es aber noch nicht getan, denn anschließend müssen Downtimes oder bei Hochverfügbarkeits-Setups Wartungsfenster eingeplant werden.

Die eigentliche Frage ist hier doch aber, wieso Storage-Systeme immer größere CPUs besitzen, diese aber nur zu einem geringen Prozentsatz ausnutzen. Gibt es an dieser Stelle vielleicht noch Optimierungspotenzial?

Storage als Compute Node

Hinter der Frage steht die Idee, ob man dem Speichersystem zusätzlich zu der sowieso enthaltenen starken CPU ein wenig mehr RAM spendieren könnte - bei den aktuellen RAM-Preisen ist das kein großer Kostenfaktor -, um diesen zusätzlich als Compute Node nutzen zu können.

Durch eine solche Konvergenz der Systeme könnten in einem einzigen Arbeitsgang Energie- und Anschaffungskosten drastisch reduziert werden. Wie so etwas aussehen kann, schauen wir uns mit Hilfe der Projekte Openattic (Storage), Ceph (Object Store) und Openstack (Cloud-Framework) an.

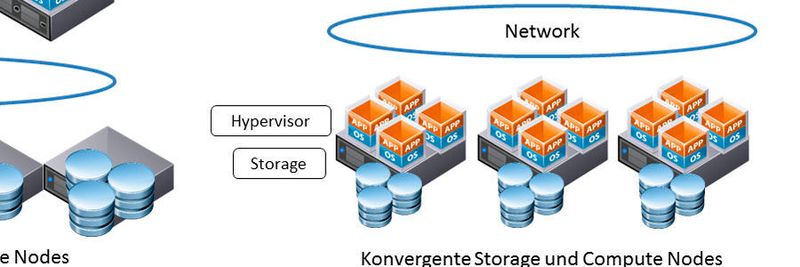

Wie die Abbildung Konvergenz zeigt, ist mit normalen Storage-Herstellern an ein solches modulares Setup nicht zu denken. Die in sich geschlossenen und nach außen meist abgekapselten Storage-Systeme lassen keinerlei Änderung oder Erweiterung jenseits der Storage-Funktionalitäten zu. Die meisten Systeme enthalten zwar mittlerweile eine zentralisierte API und SDS-Funktionalität (Software-Defined Storage), damit lassen sich aber trotzdem weder funktionelle noch separate Software-Erweiterungen ausbringen.

Solch ein System ist weiterhin nur für die Funktionalitäten von Storage-Diensten zuständig. Das Open Source-Projekt Openattic dagegen bietet ein konvergentes System, das heißt, es lässt sich gleichzeitig als Storage und Compute Node einsetzen.

Hochverfügbares Framework mit Openattic

Openattic ist ein Open Source Framework für das Storage Management. Das Projekt hat das Ziel, eine zentrale Instanz zur Verwaltung der Storage-Funktionen eines Linuxsystems zu bieten. Die integrierte Multinode-Fähigkeit von Openattic ermöglicht das Verwalten von mehreren tausend Storage Nodes aus einer zentralen Weboberfläche heraus.

Es umfasst viele Funktionalitäten, die auch proprietäre Hersteller anbieten, u.a. Snapshots, Deduplizierung, Spiegelung oder das Klonen und Wiederherstellen von Volumes. Dadurch, dass Openattic als Erweiterung auf einem Standard Linux Derivat aufsetzt (Debian oder Ubuntu), kann es auf fast jeglicher Hardware ausgebracht werden.

Das heißt, dass aus jeder bestehenden oder neu angeschafften Hardware ein Openattic Storage Node gemacht werden kann, wenn sie in der Lage, ein Linux Derivat zu beheimaten. Über die Weboberfläche von Openattic lassen sich die Werkzeuge des Linux Systems einfach verwalten.

Dazu zählt neben den Standard-Tools wie NFS, CIFS und iSCSI auch DRBD, FC oder Hochverfügbarkeit mit Pacemaker. Verbinden wir dieses Storage Management Framework mit dem Object Store von Ceph, erhalten wir in wenigen Konfigurationsschritten einen hochverfügbaren und unbegrenzt skalierbaren Speicherplatz auf sehr hohem Niveau.

Ein Ceph-Gehirn, viele Speicherzellen

Ceph ist ein Open Source Object Store, der die Erstellung eines komplett skalierbaren und hochverfügbaren Storage über Rechnergrenzen hinaus ermöglicht. Fast jede Hardware kann zu einem Ceph Node umgewandelt werden, dazu ist nur die Installation des Ceph Paketes auf dem entsprechenden Server notwendig. Anschließend kann Ceph die Festplatten des Servers verwalten und exportieren.

Die integrierten Systeme arbeiten zusammen in einer Art Clusterverbund. Ceph sorgt dafür, dass die Außenwelt diesen Verbund als einen einzelnen großen Storage Node wahrnimmt. Der große Vorteil an Ceph ist, dass beliebig viele Storage Nodes zu einem Ceph-Verbund zusammengefasst werden können. Im laufenden Betrieb können weitere Server hinzu- oder weggenommen werden, je nachdem, was im Anwendungsfall gerade benötigt wird.

Intelligente Fehlerbehebung

Ceph deckt die Themen Redundanz und Verfügbarkeit ab. Das heißt, dass sich der Administrator keine Gedanken mehr über die RAID-Konfiguration seiner Server machen muss. Der Ausfall einzelner Server hat keinerlei Einfluss auf die Verfügbarkeit des Clusters.

In Ceph lassen sich sogenannte Crushmaps erstellen, mit denen die Anzahl der Replikate der Datensätze auf den einzelnen Storage Nodes festgelegt wird. Diese Replikationsmaps sind so granular, dass sogar das Abbilden einer einzelnen Festplatte möglich ist.

Dadurch können so ziemlich alle Anwendungsszenarien der realen Welt abgebildet werden, ob ein mittelständisches Unternehmen mit nur einem Rechenzentrum und drei Servern oder einem Großkonzern mit weltweit verteilten Servern.

Ceph arbeitet mit verteilten Object Stores, sodass er beim Ausfall einer Komponente selbstheilend ist und – im Gegensatz zu den meisten anderen Systemen – keinen Single Point of Failure besitzt. Dahinter steht eine intelligente Architektur, die in einem Fehlerfall selbständig entscheiden kann, welche Maßnahmen ergriffen werden müssen.

Cloud Computing Plattform

Storage Nodes müssen also in Zukunft nicht nur Zulieferer für Virtualisierungsserver sein, sondern können beide Aufgaben gleichzeitig übernehmen. Jetzt bleibt noch die Frage offen, mit welcher Software die Virtualisierungsumgebung verwaltet und konfiguriert werden kann.

Für die Mammutaufgabe, die immer komplexer werdenden IT-Infrastrukturen einheitlich zu verwalten, gab es bis vor kurzem noch keine Lösung, die wirklich zufriedenstellend gewesen wäre. Das änderte sich jedoch im Jahre 2010 mit dem Projektstart von Openstack.

Was ist Openstack?

Openstack ist ein Open Source-Projekt, das eine Cloud-Computing Plattform für den Aufbau von Public oder Private Clouds zur Verfügung stellt. Das im Juli 2010 durch die NASA und den Hosting-Anbieter Rackspace gestartete Projekt erlebt aktuell einen Hype, wie es keinem anderen Open Source-Projekt bislang passiert ist: fast 17.000 Entwickler und mehr als 3.400 Unternehmen, darunter HP, IBM, RedHat, Intel und VMware, sind momentan an Openstack beteiligt. Der Erfolg des Projekts ist wohl hauptsächlich darauf zurückzuführen, dass sich viele Firmen schon lange eine offene Architektur mit anpassbarer Software für Clouds wünschen. Vor dem Hintergrund von NSA- und anderen Datenbespitzelungsskandalen wird der Kontrolle über die eigenen Daten und entsprechende Sicherheitseinstellungen eine wesentlich größere Bedeutung zugemessen als noch vor fünf Jahren. Damals galten Amazon Web Services (AWS) oder die Services von Google als das Maß aller Dinge.

Was ist Openstack?

Openstack entwickelt sich immer mehr zum Klassenprimus und wird auf lange Sicht vermutlich die Cloud Software der Zukunft darstellen. Aktuell ist Openstack die einzige große Cloud Plattform, die jeden einzelnen der großen Hypervisoren (VMware, Hyper-V, KVM, XEN) unterstützt.

Die Möglichkeit, mit gemischten Cloud-Umgebungen umgehen zu können, erhöht drastisch den Workload und senkt gleichzeitig die Betriebskosten. Die eingesetzten Module für Compute und Storage können unabhängig voneinander konfiguriert werden. Openstack legt keinen Wert darauf, wo Daten und VMs beim Erstellen abgelegt werden.

Das System interessiert sich nur dafür, dass am Ende das gewünschte Volume oder die virtuelle Maschine zur Verfügung stehen. Dadurch kann der Openattic-Knoten problemlos sowohl als Datenspeicher und Virtualisierungshost integriert werden.

Scale-Out dank Konvergenz und Ceph

Die Flexibilität dieser konvergenten Systeme wird erst bei der Erweiterung der Infrastruktur sichtbar. Standardlösungen bieten die Möglichkeit, bestehende Storage-Systeme durch Scale-Up-Verfahren zu erweitern. Dabei werden die alten Festplatten durch neue und größere ersetzt oder komplette Erweiterungseinheiten installiert.

Bietet der aktuelle Speicher keine Anschlussmöglichkeiten mehr, wird eine komplett neue Hardware angeschafft oder gänzlich auf die Erweiterung verzichtet. Ein ähnliches Vorgehen gibt es bei der Erweiterung der Virtualisierungsnodes mit dem Unterschied, dass die Anschaffung eines weiteren Servers meistens nicht so teuer ist wie die Erweiterung des bestehenden Speichers.

Diese kostenintensive Option ist mit den konvergenten Systemen von Openattic in Verbindung mit Ceph nicht nötig. Dadurch, dass Commodity Hardware zur Installation eines weiteren Nodes genutzt werden kann, lassen sich die Investitionen auf ein Minimum reduzieren.

Verbund-Management

Auch die recht müßige Erweiterung des bestehenden Speicherplatzes und die Anbindung an die Virtualisierungsumgebung entfallen. Wie die Abbildung Scale-out zeigt, können durch den modularen Aufbau der Kombination Openattic-Ceph perfekte konvergente Scale-Out Nodes erstellt werden.

Ein weiterer Vorteil ist, dass mit Openattic nicht jeder Server separat in seiner eigenen Oberfläche administriert werden muss (was bei mehreren hunderten von Storage Nodes sehr zeitraubend sein kann). Diese Aufgabe lässt sich zentral aus der Weboberfläche heraus erledigen. Mit einigen wenigen Konfigurationsschritten lässt sich ein weiterer Server dem Openattic- und Ceph-Verbund hinzufügen, der sofort genutzt werden kann.

Das Setup ist dabei sehr flexibel, sodass das System nur um eine einzelne Festplatte, Erweiterungseinheit oder eine ganze Reihe von Servern vergrößert werden kann. Werden irgendwann weitere Virtualisierungsserver nötig, überprüft mach einfach, ob der Speicher vielleicht doch noch Ressourcen hat, die er zur Verfügung stellen kann.

Fazit

Dass sich Server konsolidieren und auf virtuellen Clustern zusammenziehen lassen, ist mittlerweile bekannt. Dass man diese jedoch gleichzeitig auf dem Storage-Server abbilden kann, wissen viele Administratoren nicht. Wieso also die zur Verfügung stehende Performance nicht ausnutzen und damit das Rechenzentren aufräumen und gleichzeitig das Budget schonen?

Die aufgesetzten konvergenten Openattic-Systeme sind mit wenigen Mausklicks in Openstack integriert und können als zusätzlicher Hypervisor dienen. Durch die Anbindung von Ceph ist der Administrator in Zukunft nicht mehr auf aufwändige Erweiterungen seiner Speicherressourcen angewiesen oder muss hohe Ausgaben genehmigen lassen. Er kann einfach beim Distributor seiner Wahl Standard-Hardware einkaufen und mit der Konvergenz beginnen.

Artikelfiles und Artikellinks

(ID:43732680)

:quality(80)/p7i.vogel.de/wcms/b5/ad/b5ade2e50671d986cabb091cc33de39f/0127234511v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/2d/69/2d69b27f3f8f5f290f7ae2b3d9123b1b/0127206601v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/94/d2/94d28e3faac411c22b54d80ea354d2e3/0124559320v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ca/b3/cab330ef06324344f47f1715af71ffb8/0121296602v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/07/4b/074b768fc6cd441f6ffe5f37ef28e9f0/0129260086v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/8e/65/8e65beda5e1799415f8b42648c345ac2/0128829864v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/87/b0/87b06b798102aa4b9947e5702459b72c/0127725341v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/cc/f2/ccf2ca3c61ebd1f543ddfdeafdc371d8/0129532315v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/7e/62/7e6241a450fc3d2c4fb4b66431bb346a/0129449658v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/2b/eb/2beb093a4b15a43e77a5fddc51617012/0129334977v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/f7/81/f781424a8c09c2958f530e353259f552/0129570093v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/69/24/6924ee13482bf6c15da7ee7ea1150ae3/0128919402v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ae/48/ae484d253878313823c4e4c513dd6b17/0129603520v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ae/33/ae338789aff1d1f96a948ed70c45f8f2/0129566793v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/ff/6d/ff6d1afe1f2b3a896699b545f4f74abb/0129409341v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/51/96/51965391328bb2fd4e6e616ebcaa486d/0129531873v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/e4/83/e48315c7b4fd3a018ed443683a58b4b1/0128408290v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/34/04/340462e2780b44a425ef8b592e9f6fa6/0129136839v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/b2/5e/b25e7987732ebb16ed51a2e7f1ede807/0129670176v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/1b/7f/1b7fbe21d96ecca26e39c0eba3a1c3d7/0129345051v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/d8/7c/d87c0895a1fd1e2a8eea97f2e6525844/0129222145v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/37/ea/37ea3b117cd6e97340697c2f7c96d3c9/0129216654v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/c0/44/c0444de775b44640d2a4a0d8016636a8/0129214786v1.jpeg)

:quality(80)/images.vogel.de/vogelonline/bdb/1552300/1552323/original.jpg)

:quality(80)/images.vogel.de/vogelonline/bdb/1644500/1644561/original.jpg)

:quality(80)/images.vogel.de/vogelonline/bdb/1641800/1641842/original.jpg)

:fill(fff,0)/p7i.vogel.de/companies/69/98/699837ff85e16/datacore-logo-700x700px.jpeg)

:fill(fff,0)/p7i.vogel.de/companies/63/db/63dbd1915b7af/2023-fastlta-logo-square-positive.jpeg)

:quality(80)/p7i.vogel.de/wcms/00/21/00210690e8efdb6f9525768f87e5e707/0121452541v1.jpeg)

:quality(80)/p7i.vogel.de/wcms/78/8d/788dc04f8fafa4997bdfb8659babb15c/0125683548v1.jpeg)